Anwendungen von Sensoren im Kontext von „Autonomous Driving“ und „Automated Guided Vehicles“

Der Einsatz geeigneter Sensoren spielt bei der Digitalisierung in allen Bereichen der Industrie und der Automatisierung eine entscheidende Rolle. Besonderes Gewicht bekommt die Erfassung von Maschinendaten vor dem Hintergrund von Industrie 4.0-Anwendungen wie „Condition Monitoring“, „Predictive Maintenance“ „Customization“ und „Produktion bis zu Losgröße 1“.

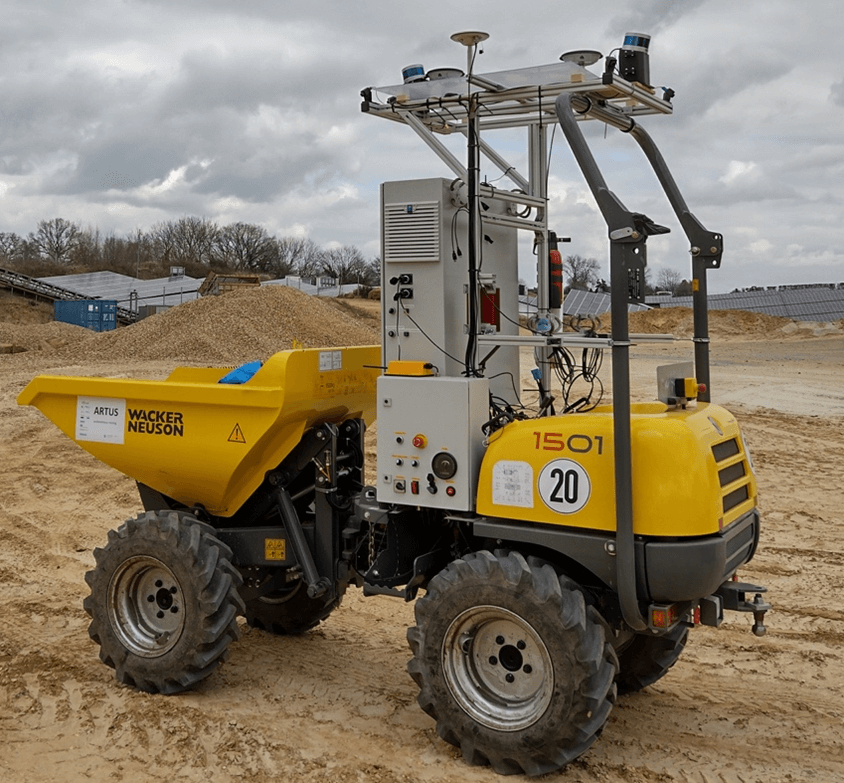

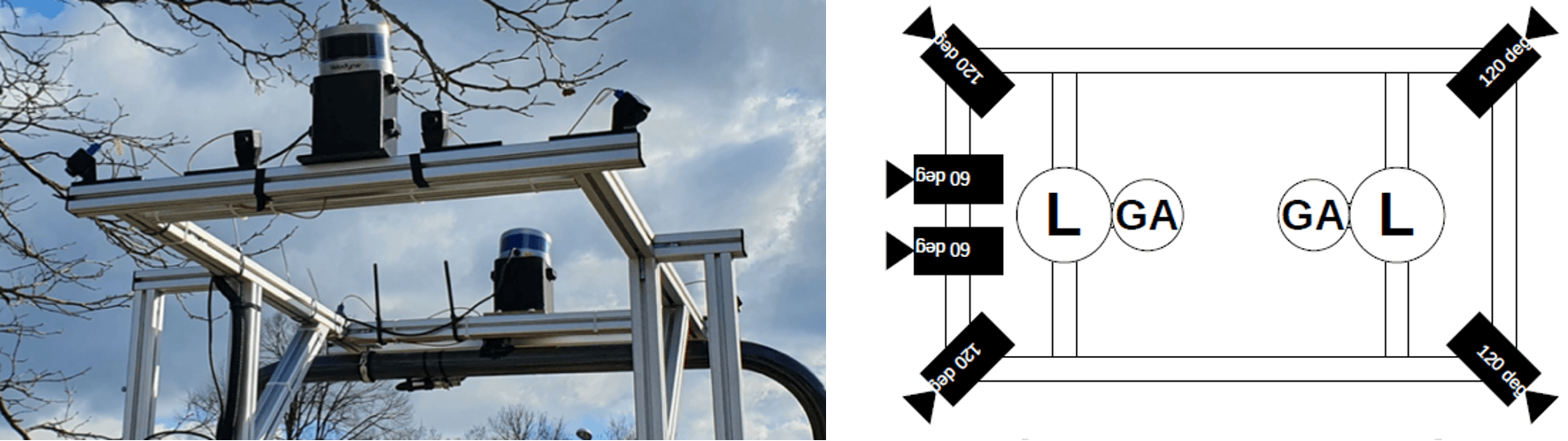

Das Thema Datenerhebung und -erfassung bekommt durch datengetriebene Anwendungen von Künstlicher Intelligenz (KI) aus dem Bereich Big Data und Tiefe Neuronale Netze weiteren Rückenwind. Dabei ist der richtige Umgang mit den Daten immens wichtig. Dies beginnt bei der Auswahl der Sensoren, der richtigen Datenerfassung und endet bei der korrekten Auswertung der gesammelten Daten. In diesem Beitrag möchte ich über zwei unserer aktuellen Anwendungen von Sensoren im Kontext von „Autonomous Driving“ und „Automated Guided Vehicles“ (AGVs) berichten.

Use-Case 1: Autonomes Fahren

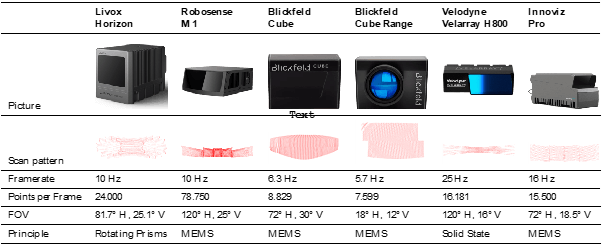

Im ersten Fall wurde als Anwendung das Autonome Fahren betrachtet. Auch wenn manche Hersteller (autonomer) Fahrzeuge glauben, dass Kameras als Sensoren für selbstfahrende Fahrzeuge ausreichen, wird diese Einschätzung nicht von allen geteilt. Man sollte technologieoffen an diese Fragestellung herangehen, um alle Möglichkeiten auf dem Weg zu autonomen Fahrzeugen auszuloten. Selbst wenn sich herausstellen sollte, dass Kameras irgendwann als Sensorik für solche Fahrzeuge ausreichen, sollte man zum jetzigen Zeitpunkt Alternativen nicht außer Acht lassen.