Datenexperten heben verborgene Schätze aus Daten

Daten sind das neue Öl und die Data-Scientisten – Datenwissenschaftler oder ab jetzt: Datenexperten – sind diejenigen, die in den Daten verborgene Informationen für sich oder andere zugänglich machen. Somit sind sie zur gleichen Zeit die Umsetzer künstlicher Intelligenz.

Die künstliche Intelligenz und ihre drei Säulen

In der Einladung zur ersten KI-Konferenz im Jahr 1956 am Dartmouth College in Hanover, New Hampshire/ USA, schreibt John McCarthy über die Hypothese, dass „jeder Aspekt des Lernens oder irgendeines anderen Merkmals der Intelligenz im Prinzip so genau beschrieben werden kann, dass eine Maschine gemacht werden kann, um sie zu simulieren“. Seitdem gibt es viele weitere Definitionen von KI, die KI-Welt hat sich aber bis dato nicht auf eine einigen können.

Für den Alltagsgebrauch könnte man sagen: KI ist, wenn ein Algorithmus als Werkzeug in den Händen eines Menschen Muster in Daten erkennt und ihn scheinbar intelligent unterstützt.

KI kommt in vielen Ausprägungen daher, die heute meist angewendete ist das maschinelle Lernen. Dabei geht es darum, dass Computerprogramme ohne explizite Programmierung lernen. Die dazu eingesetzten Algorithmen sind oft sogenannte künstliche neuronale Netze, welche dem menschlichen Gehirn lose nachempfunden sind. Eine besondere Methode dieses maschinellen Lernens ist das Deep Learning oder tiefes Lernen, bei dem künstliche neuronale Netze mit einer großen Anzahl an Zwischenschichten eingesetzt werden.

Schon früher hat auch die Statistik oder das Data Mining Muster in Daten erkannt. Während aber die Statistik zurückblickt, sich damit befasst, was geschehen ist, und das Data Mining versucht, einen Einblick in das, was war oder ist, zu verschaffen, gibt das maschinelle Lernen meist einen Ausblick: Was wird geschehen? Und was ist zu tun, damit nicht gewollte Situationen (Anlagenstillstand / Klimaänderung) nicht eintreten.

Die wichtigsten Zutaten oder besser: Säulen des modernen maschinellen Lernens sind Daten, Algorithmen und Prozessoren.

Daten übernehmen die Rolle des weltweiten Wirtschaftstreibers vom Öl – wobei seit einiger Zeit Öl wieder verstärkt von sich hören lässt! So wie aus Rohöl Benzin destilliert werden muss, so müssen verborgene Informationen von den Datenexperten aus den Daten gehoben werden. Daten stellen den neuen Produktionsfaktor – zusätzlich zu Boden, Kapital und Arbeitskraft – dar, sie sind die neue Währung.

Ein Algorithmus ist eine Handlungsanweisung zur Lösung eines Problems, die selbst auch wieder Handlungsanweisungen beinhalten kann. Es gibt Basisalgorithmen zum Sortieren, Suchen, Indexieren, Selektieren, Umdrehen, Zusammenführen oder Drucken. Algorithmen werden in Programmiersprachen wie C, C++, Java oder Python – dem aus den Niederlanden stammenden, mittlerweile weltweiten Standard für Data Science und anderen Anwendungen implementiert. Heute sind die wichtigsten Basisalgorithmen für das maschinelle Lernen auf Open-Source-Plattformen wie Github frei verfügbar oder eingebettet in KI-Dienstleistungsplattformen.

Das Moore’sche Gesetz bezeichnet die Prophezeiung des Intel-Mitgründers Gordon Moore vor über fünfzig Jahren, die Anzahl der Prozessor-Transistoren würde sich in Zukunft jedes Jahr bei etwa gleichbleibendem Preis verdoppeln. Besaß der erste Prozessor von 1971 (Intel 4004) etwa 2.400 Transistoren, sind es bei den heutigen, modernen Prozessoren im etwa 10 Milliarden. Dies ist eine tatsächliche Verdoppelung alle etwa zweieinviertel Jahre.

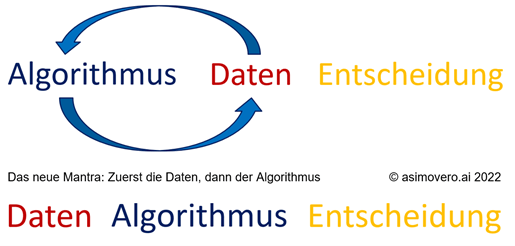

Während in den ersten fünfzig Prozessor-Jahren eine Anwendung programmiert, getestet und dann in der Praxis mit Daten gefüttert wurde und eine Lösung berechnete, dreht sich diese Reihenfolge bei KI immer öfter um. Statt der Reihenfolge Daten -> Algorithmus -> Entscheidung, kommen in den modernen KI-basierten Anwendungen immer häufiger zuerst die Daten. Und der KI-Algorithmus findet in den Daten Muster, als Basis für Entscheidungen.